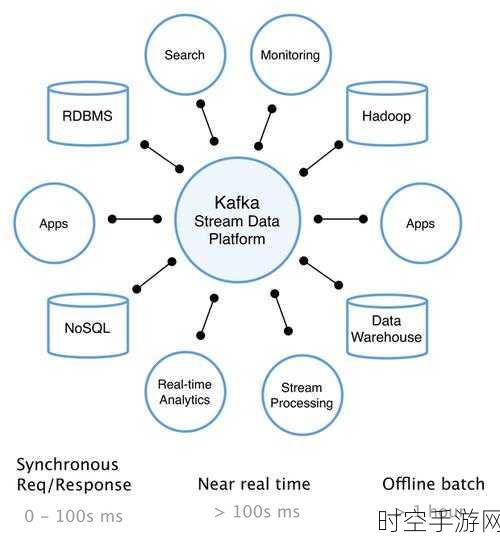

在当今的数据处理领域,Flume 向 Kafka 进行数据传输的稳定性至关重要,稳定的数据传输能够保障系统的高效运行,避免数据丢失和错误,如何才能确保这一过程的稳定呢?

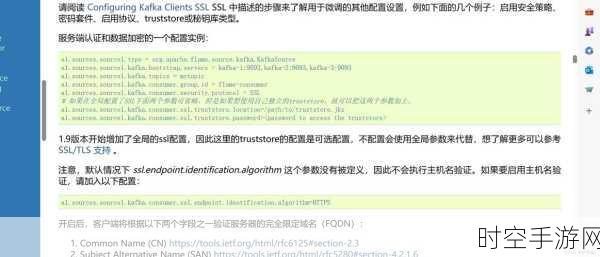

要实现 Flume 向 Kafka 稳定传输数据,合理的配置是基础,在 Flume 的配置中,需要对数据源、通道和接收器进行精细的设置,针对数据源,要根据数据的产生速率和特点,调整缓冲区大小和采集频率,对于通道,要选择合适的类型和参数,以平衡数据存储和传输的性能,而接收器方面,则要确保与 Kafka 集群的连接参数准确无误,包括主题名称、分区策略等。

优化网络环境也是保障稳定传输的重要环节,网络的稳定性和带宽直接影响数据传输的效果,确保 Flume 与 Kafka 所在的网络环境畅通无阻,减少网络延迟和丢包现象,可以通过监测网络指标,如延迟、吞吐量和丢包率,及时发现并解决潜在的网络问题。

监控和预警机制不可或缺,实时监控 Flume 向 Kafka 传输数据的过程,及时发现异常情况,比如数据传输速率的突然下降、数据丢失等,通过设置合理的预警阈值,一旦出现异常,能够迅速通知相关人员进行处理,避免问题扩大化。

定期的测试和优化是持续保障稳定的关键,通过模拟不同的业务场景和数据量,对 Flume 与 Kafka 的传输进行压力测试,根据测试结果,不断调整配置和优化系统,以适应实际业务的需求。

要确保 Flume 向 Kafka 数据传输的稳定,需要从配置、网络、监控和测试优化等多个方面入手,全面考虑,精心部署,才能为数据处理系统的稳定运行提供有力的支持。

文章参考来源:相关技术论坛及官方文档。